Imagem: divulgação/Força Aérea dos EUA

Recentemente, os Estados Unidos concluíram com sucesso o primeiro voo da aeronave experimental XQ-58A Valkyrie, um drone pilotado por inteligência artificial, que pode se tornar uma adição poderosa à sua frota de caças tradicionais.

O objetivo é fornecer aos pilotos humanos uma equipe de robôs altamente capazes para combater, segundo publicou o The New York Times. O Valkyrie é equipado com motor de foguete, tem autonomia para voar uma distância da largura da China, tem design furtivo e é capaz de transportar mísseis. Por fim, esse protótipo também é equipado com sensores, o que o torna capaz de identificar e avaliar ameaças inimigas, e após receber autorização humana, atacá-las.

Além dos benefícios em batalha, esses drones podem ser muito mais baratos para produzir. Por exemplo, enquanto cada caça F-35 custa US$ 80 milhões, esses drones têm um valor aproximado de US$ 3 milhões – embora modelos mais sofisticados possam chegar a US$ 25 milhões. Por isso, a Força Aérea planeja construir de mil a 2 mil robôs aéreos.

Por outro lado, a utilização da inteligência artificial em armas letais levanta preocupações sobre a autonomia desses dispositivos. Enquanto a IA oferece benefícios consideráveis, há preocupações éticas sobre a terceirização da decisão de matar para máquinas, levando a questionamentos sobre o quanto de autonomia deve ser concedido a essas armas.

"Você está ultrapassando um limite moral ao terceirizar a matança para máquinas – ao permitir que sensores de computador, em vez de humanos, tirem vidas humanas."

Mary Wareham, diretora de ativismo na divisão de armas da Human Rights Watch

Ainda assim, o Pentágono recentemente revisou uma política sobre a utilização de IA em sistemas de armas com autonomia para matar. Com isso, qualquer plano para construir e usar tal armas devem ser revisado e aprovado por um painel militar especial.

Ainda sobre o nível de autonomia, o Pentágono afirmou que a possibilidade desses drones serem capazes de atacar sem a aprovação humana era demasiado hipotética para ser respondida.

No entanto, os próprios oficiais da Força Aérea disseram que as máquinas não são inteligentes da mesma forma que os humanos. Além disso, basta observar que os carros autônomos têm cometido uma série de erros, incluindo acidentes fatais.

Entre os desafios na construção dessas aeronaves de combate colaborativas, estão as discrepâncias entre as simulações executadas pelo computador antes do voo e o que o drone faz efetivamente no ar. Além disso, estão os comportamentos com potencial prejudicial que podem surgir.

Outra questão a ser superada é a necessidade que esses drones sejam capazes de perceber o mundo ao redor deles. Afinal, os inimigos em potencial podem usar truques – como, por exemplo, criar uma camuflagem virtual para fazer o robô acreditar que está vendo outra coisa.

Por fim, será necessário construir a confiança entre os pilotos e esses drones. Embora os pilotos da Força Aérea tenham experiência em confiar na automação – como em sistemas anticolisão –, é significativamente diferente voar ao lado de uma máquina com comportamentos incomuns, baseados no processamento de milhares de dados em tempo real.

A incorporação de inteligência artificial nas armas da Força Aérea representa uma mudança significativa na maneira como a instituição adquire suas ferramentas fundamentais.

Em vez de apenas buscar hardware dos principais contratantes como a Lockheed Martin e a Boeing, a ênfase agora é colocada no software que pode aprimorar as capacidades dos sistemas de armas. Além disso, permitiria a introdução de empresas de tecnologia mais recentes nessa cadeia de suprimentos, o que, por sua vez, traria mais competição e inovação para um sistema usualmente lento e avesso ao risco.

Embora desafios técnicos e éticos ainda precisem ser superados, a Força Aérea está otimista que, em cerca de cinco a dez anos, poderá desenvolver um sistema de combate aéreo baseado em inteligência artificial eficiente e confiável.

Fonte: Olhar Digital

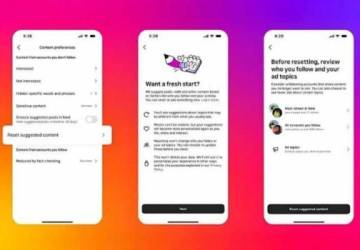

Tecnologia Instagram vai permitir reiniciar o algoritmo para esquecer suas informações

Tecnologia Instagram vai permitir reiniciar o algoritmo para esquecer suas informações  Tecnologia Vídeo: Robô chinês lidera rebelião e incentiva colegas a abandonarem seus postos

Tecnologia Vídeo: Robô chinês lidera rebelião e incentiva colegas a abandonarem seus postos  ESTUDO ESTUDO | Infoblox Threat Intel identifica novos hackers de DNS ligados ao sequestro de domínios Infoblox Threat Intel identifica novos hackers de DNS ligados ao sequestro de domínios

ESTUDO ESTUDO | Infoblox Threat Intel identifica novos hackers de DNS ligados ao sequestro de domínios Infoblox Threat Intel identifica novos hackers de DNS ligados ao sequestro de domínios